Robots.txt

Monitoring et alertes

Ne manquez jamais un changement de robots.txt. Surveillez les règles d'accès des crawlers, déclarations de sitemap et directives SEO avec des alertes automatiques quand votre fichier robots.txt est modifié. Vérifications quotidiennes.

Aucune carte de crédit requise

Surveillez votre robots.txt en 3 étapes simples

Ajoutez votre domaine

Entrez le domaine de votre site web et nous détecterons automatiquement et commencerons à surveiller votre fichier robots.txt.

Surveillance automatique

Nous vérifions quotidiennement votre robots.txt pour tout changement dans les directives, sitemaps ou règles d'accès des crawlers.

Alertes instantanées

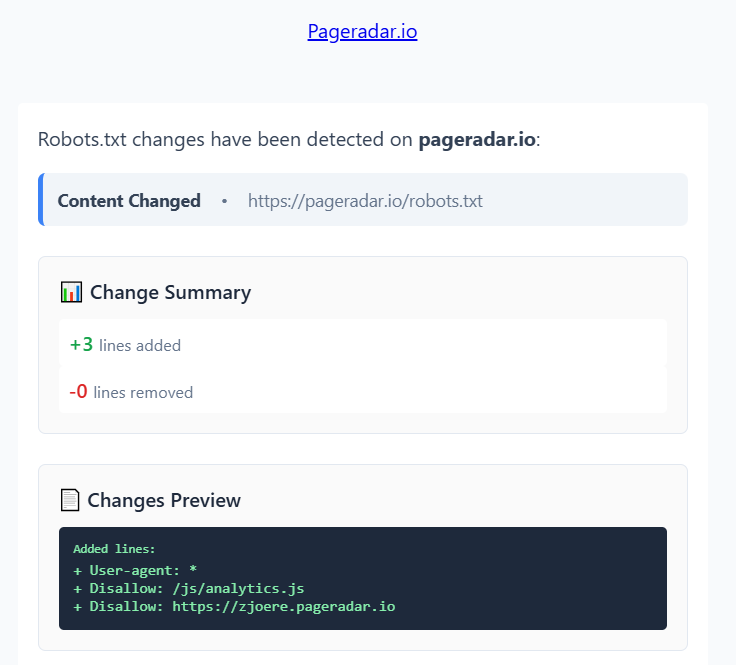

Recevez des notifications email avec diff détaillé des changements quand votre robots.txt est modifié.

Solution complète de surveillance robots.txt

Outil de surveillance professionnel conçu pour détecter chaque changement de robots.txt.

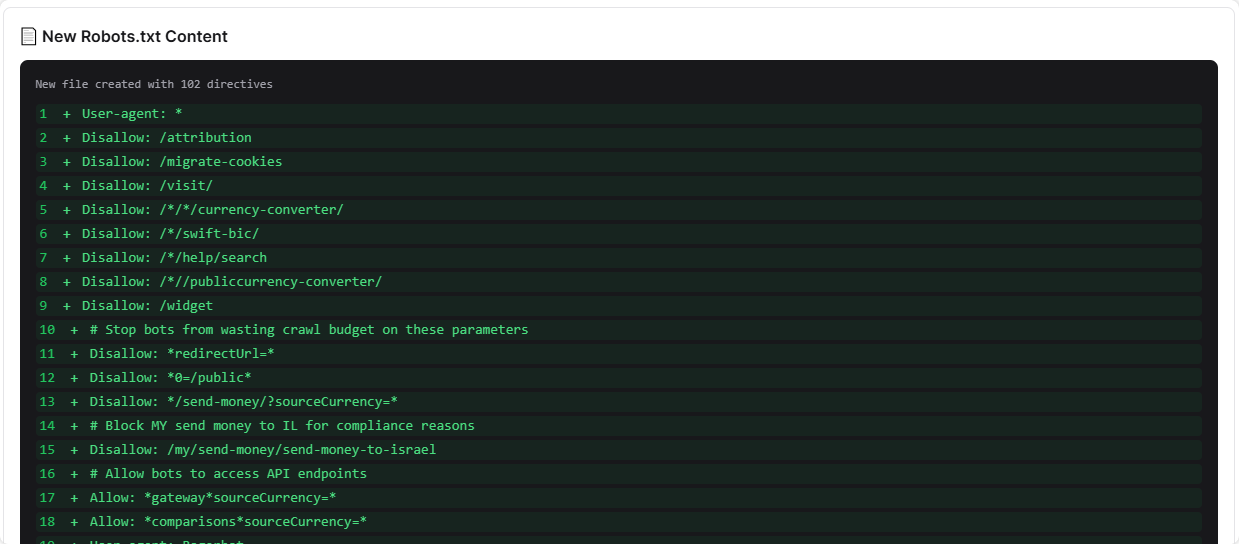

Notifications détaillées de changements

Recevez des alertes email instantanées avec diff visuel montrant exactement ce qui a changé dans votre robots.txt. Voyez les directives ajoutées, règles supprimées et paramètres modifiés.

- Comparaisons de diff visuels

- Analyse de changements au niveau des directives

- Notifications email instantanées

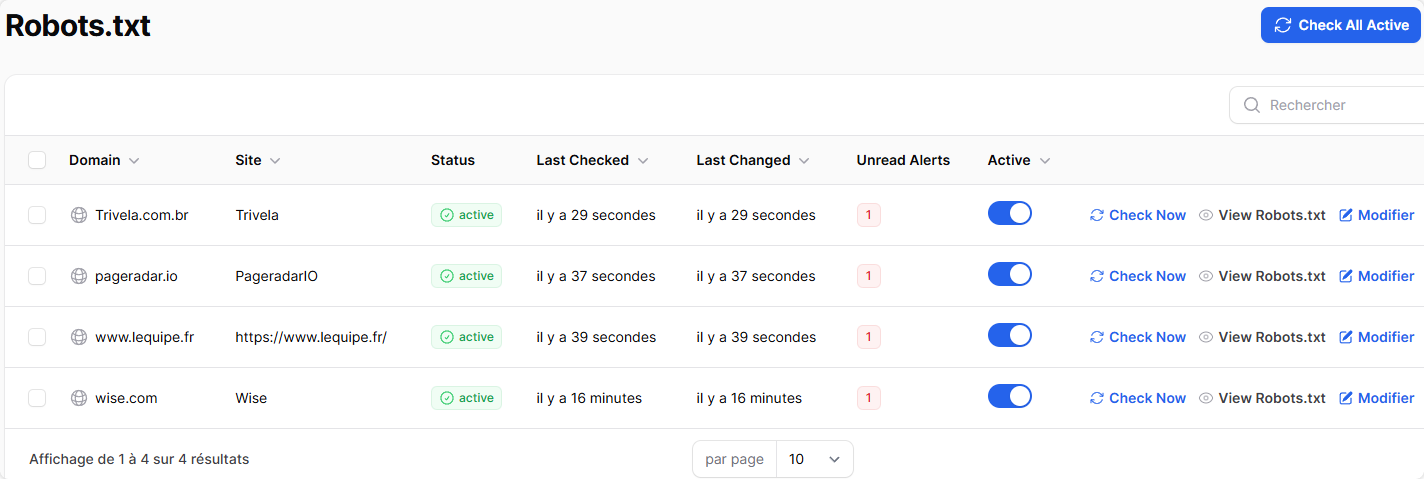

Surveillez plusieurs sites web

Surveillance centralisée de robots.txt sur tous vos sites web. Parfait pour les agences, réseaux e-commerce, migrations de sites ou entreprises avec plusieurs domaines.

- Domaines illimités

- Tableau de bord centralisé

- Fréquences de vérification personnalisées

Parfait pour les sites avec un bon référencement SEO

Sites e-commerce

Protégez l'indexation des catégories de produits et prévenez le blocage accidentel des crawlers shopping comme Google Shopping.

Sites de contenu

Surveillez les déclarations de sitemap et assurez-vous que vos articles de blog et articles restent accessibles aux moteurs de recherche.

Sites d'entreprise

Suivez les changements sur plusieurs domaines et prévenez le blocage accidentel de pages business importantes.

Pourquoi choisir PageRadar pour la surveillance robots.txt ?

| Fonctionnalité | PageRadar | Surveillance manuelle | Autres outils |

|---|---|---|---|

| Fréquence de Surveillance | Quotidienne | Quand vous vous en souvenez | Quotidienne |

| Vue diff visuelle | Intégrée | Basique | |

| Historique des changements | Chronologie complète | Limité | |

| Support multi-sites | Illimité | Chronophage | Coût supplémentaire |

| Pricing | À partir de 29€/mois | Gratuit mais peu fiable | $80+/month |

Tarification simple

Commencez à surveiller votre robots.txt aujourd'hui

Aucune carte de crédit requise. Annulez à tout moment.

Besoin d'une tarification sur mesure ?

Gros volumes ? Besoins spécifiques ? Nous proposons des solutions sur mesure pour les entreprises et agences.

- Remises sur volume disponibles

- Intégrations personnalisées

- Support prioritaire

- Gestionnaire de compte dédié

FAQ

Questions Courantes

Tout ce que vous devez savoir sur la surveillance robots.txt.

Nous surveillons quotidiennement vos fichiers robots.txt. Cela signifie que tout changement est détecté dans les 24 heures maximum, vous donnant une notification rapide de problèmes SEO potentiels.

Nous suivons tous les changements incluant les directives User-agent, règles Disallow/Allow, déclarations Sitemap, paramètres Crawl-delay et toute autre directive robots.txt.

Oui ! Lorsque vous ajoutez un domaine sans fichier robots.txt, nous détecterons automatiquement quand le fichier est créé et commencerons à le surveiller, vous envoyant une notification de bienvenue avec le contenu initial.

Vous pouvez surveiller un nombre illimité de domaines sur tous les plans (dans les limites de votre plan).

Oui, nous stockons l'historique complet de tous les changements robots.txt pour chaque domaine surveillé. Vous pouvez voir l'évolution de votre fichier robots.txt dans le temps avec horodatages + diffs visuels.

Nous vous alerterons immédiatement si votre fichier robots.txt retourne une erreur 404 ou devient inaccessible. Cela vous aide à détecter rapidement les problèmes.

Absolument ! Lors de migrations de sites, les règles robots.txt peuvent changer accidentellement lors du passage vers de nouveaux hébergements ou plateformes CMS. Notre surveillance vous assure de détecter les changements involontaires qui pourraient bloquer les moteurs de recherche.